Понятие объяснимого искусственного интеллекта (XAI) является одной из ключевых тем в области ИИ и вызывает большой интерес как у научных сообществ, так и у представителей бизнеса. XAI относится к сфере исследований, направленных на разработку технологий, которые обеспечивают возможность понимать, объяснять и интерпретировать решения, принимаемые ИИ системами. Рассказываем про объяснимый искусственный интеллект: что это, для чего он нужен и в каких областях применяется.

Что такое объяснимый искусственный интеллект

Искусственный интеллект имеет огромный потенциал во многих областях, однако его решения, основанные на сложных алгоритмах и нейронных сетях, не являются очевидными для человека. Объяснимость, в данном контексте, означает способность объяснить принципы работы искусственного интеллекта таким образом, чтобы исследователи, программисты и пользователи имели возможность понять эти решения.

Важность разработки концепции объяснимого искусственного интеллекта обусловлена несколькими факторами:

- Объяснимость позволяет повысить доверие к искусственному интеллекту и его решениям, особенно в сферах, где принимаемые решения могут иметь серьезные последствия для людей.

Например: в области медицины, финансов и транспорта прозрачность и объяснимость алгоритмов играют решающую роль. - Объяснимость способствует лучшему пониманию действий искусственного интеллекта, что может быть полезно для обучения искусственных систем под контролем человека. Разработчики и пользователи могут получить информацию о принципах работы системы, об их предпочтениях и слабостях, и, соответственно, вносить соответствующие изменения и улучшения.

- Область объяснимого искусственного интеллекта стимулирует развитие новых методов к созданию более прозрачных искусственных интеллектуальных систем. Это позволяет разработчикам создавать инновационные продукты и решения, которые приносят пользу обществу и имеют потенциал для существенного вклада в различные отрасли.

Основы ОИИ

Объяснимость является неотъемлемым требованием для принятия решений, обеспечения ответственности и доверия в сфере искусственного интеллекта. В контексте ИИ, где умение самостоятельно принимать решения является важным аспектом, объяснимость становится необходимой для обеспечения оправдания и ответственности за действия ИИ систем.

Она также играет важную роль в формировании доверия со стороны пользователей и общества в целом. Предоставление объяснений принятия решений помогает отследить ошибки и недостатки в работе, что позволяет улучшить их работу и повысить эффективность использования.

Методы и техники объяснимого искусственного интеллекта

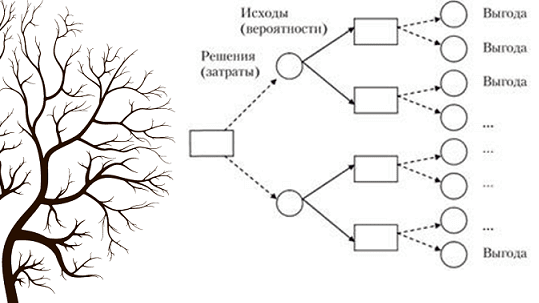

В основе достижения объяснимости лежат различные подходы, которые включают применение правил, логики, деревьев решений и прозрачных моделей машинного обучения.

- Правила. Правила представляют собой формализованные выражения, которые описывают специфические условия и действия. В контексте получения объяснимости в искусственном интеллекте, правила позволяют четко определить, какие шаги или решения принимаются и почему. Этот подход обеспечивает понятность и легкость интерпретации процессов, что делает его важным для секторов, где требуется высокий уровень объяснимости, таких как юридическая сфера или медицина.

- Логика. Логика является фундаментальным инструментом для формализации рассуждений и выводов. В контексте объяснимости искусственного интеллекта, применение логики позволяет обеспечить строгую и последовательную основу для объяснения принятых решений. Этот подход особенно полезен в случаях, когда требуется не только объяснить принятое решение, но и доказать его корректность.

- Деревья решений. Деревья решений представляют собой графическую модель, которая помогает систематизировать и классифицировать различные возможные варианты принимаемых решений. Деревья решений обладают простой и интуитивно понятной структурой, что делает их подходящими для задач объяснения принятых решений. Они позволяют четко наглядно представить логику рассуждения и процесс принятия решения, что облегчает интерпретацию и позволяет пользователям легко понять логику системы и ее выводы.

- Прозрачные модели. В отличие от более сложных и непонятных черных ящиков, прозрачные модели позволяют пользователям понять, как именно каждый из входных параметров влияет на итоговый результат или прогноз. Этот подход позволяет лучше контролировать и объяснять принимаемые решения и способствует повышению доверия к системе искусственного интеллекта.

Применение XAI в практических областях

В последние годы развитие и применение ИИ стало важной частью многих практических областей, предоставляя возможности для автоматизации процессов, оптимизации решений и создания новых технологических решений.

Однако, вместе с прогрессом появилась необходимость в обеспечении объяснимости принимаемых алгоритмами ИИ решений в следующих секторах: медицина, финансы и автономные транспортные средства.

Медицина

В медицине значение объяснимости ИИ выходит на первый план. Врачи и пациенты требуют понимания принимаемых алгоритмами решений, поскольку они имеют непосредственное отношение к здоровью и жизням людей. Врачи нуждаются в объяснении оснований, по которым алгоритмы ИИ предлагают определенные диагнозы и лечебные рекомендации.

Пациенты, в свою очередь, хотят иметь возможность понять причины, по которым было принято то или иное решение относительно их здоровья.

Финансовый сектор

Прозрачность финансовых прогнозов и обоснование инвестиционных решений важны для инвесторов и страховых компаний. Искусственный интеллект, способный объяснить свои прогнозы и принятые решения, помогает клиентам лучше понять логику работы финансовых алгоритмов и выстроить более обоснованные инвестиционные стратегии. Это также способствует повышению доверия к автоматическим системам и минимизации рисков, связанных с финансовыми решениями.

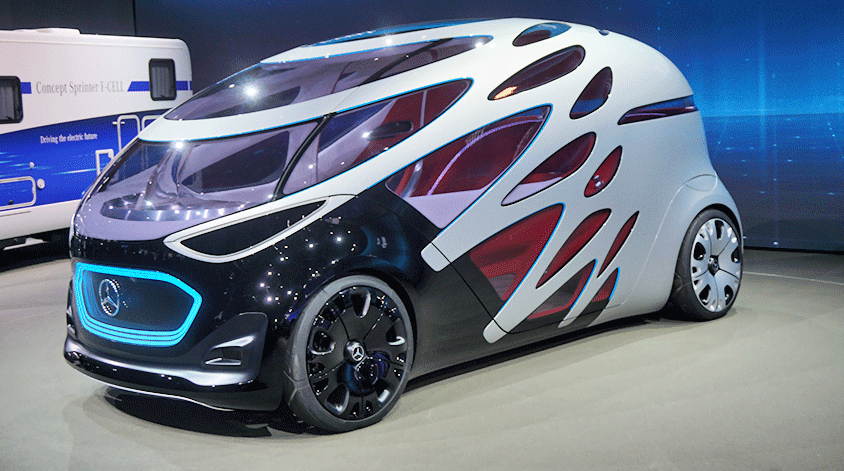

Автономные транспортные средства

Объяснимый ИИ позволяет объяснить принимаемые автоматические решения всем участникам дорожного движения. Это включает объяснение причин выбора определенного маневра, предсказание действий других участников движения и обоснование принимаемых алгоритмами ИИ решений в экстренных ситуациях.

Благодаря объяснимости ИИ, автономные транспортные средства способны создавать доверие и обеспечивать безопасность на дорогах.

Заключение

XAI представляет собой важную область исследований, которая стремится сделать процесс принятия решений и предсказаний искусственных интеллектуальных систем более понятным для людей.

Основная проблема современных моделей AI (глубокое обучение, нейронные сети) заключается в их сложности и непрозрачности. В то время как эти модели способны добиваться выдающихся результатов в различных областях, их внутреннее функционирование остается загадкой для их пользователей и даже для самих разработчиков.

RU

RU EN

EN