Липсинк-видео — технология синхронизации движений губ с аудиодорожкой, которая перестала быть прерогативой киностудий и превратилась в инструмент для массового творчества. Сегодня их используют не только для дубляжа фильмов или озвучки персонажей, но и в рекламе, TikTok-роликах, играх и даже виртуальных аватарах.

Благодаря искусственному интеллекту создание реалистичной синхронизации стало доступным даже рядовым пользователям, а рынок сервисов стремительно растет. В этой статье — от основ технологии до лучших AI-платформ и этических вопросов.

Исторический экскурс

В 1930-х дубляж фильмов был хаотичным: актеры озвучки часто записывали реплики без видеоряда, что приводило к комичным нестыковкам (например, в советском дубляже «В джазе только девушки»). Ситуация улучшилась с изобретением ADR-технологии (Automated Dialogue Replacement) в 1950-х: актеры переозвучивали роли, глядя на экран, но синхронизация оставалась ручной.

Первый шаг к автоматизации сделала компания Kayser-Threde в 1986 году, разработав систему LipSync Pro — софт, который визуализировал аудиоволны и помогал редакторам точнее совмещать речь с видео. Однако настоящая революция началась в 2010-х с приходом искусственного интеллекта.

- 2016: Проект Lyrebird представил ИИ, который копировал голос человека за 1 минуту аудио и генерировал синхронизированную анимацию.

- 2018: Adobe Voco (позже закрытый из-за этических рисков) показал, как нейросети могут редактировать речь в аудиодорожке, автоматически подстраивая движения губ в видео.

- 2021: Synthesia запустила платформу для создания видео с цифровыми аватарами, где ИИ генерирует артикуляцию из текста, минуя этап записи голоса.

Основы липсинк: от кукольной анимации до нейросетей

Липсинк (синхронизация губ) прошел путь от кропотливой ручной работы до революции, которую запустил искусственный интеллект. В 1930-х аниматоры Disney, создавая первых говорящих персонажей вроде Микки Мауса, вручную рисовали каждое движение губ, ориентируясь на фонограммы. Эта техника легла в основу классического дубляжа: даже в 90-х при локализации фильмов актеры озвучки часами подстраивали свою артикуляцию под мимику героев. Но все изменилось с появлением машинного обучения.

Современные алгоритмы анализируют аудио не только на уровне слов, но и фонем — минимальных звуковых единиц языка. Например, нейросеть Wav2Lip, разработанная индийскими исследователями, учится сопоставлять аудиоволны с видео, предсказывая движения губ даже на записанных «в тишине» роликах. А платформы вроде Adobe Character Animator используют реалтайм-трекинг лица через веб-камеру, автоматически адаптируя мимику аватара под голос пользователя.

Но главный прорыв — генеративные модели (GAN, Diffusion), которые создают движения губ «с нуля». Так, сервис Synthesia генерирует видео с цифровыми дикторами, чья артикуляция идеально совпадает с заданным текстом, а DeepMotion анимирует 3D-аватары, учитывая даже акценты и эмоциональные нюансы речи. Технологии уже применяют не только в кино: например, в 2023 году стартап Respeecher восстановил голос актера Валерия Золотухина для фильма «Чернобыль. Зона отчуждения», синхронизировав его с архивными кадрами. Подробнее о сервисах будем говорить ниже.

Однако ИИ — не панацея. Для сложных задач, вроде синхронизации песен или эмоциональных монологов, до сих пор используют гибридные подходы. Студия Framestore (создатели визуальных эффектов для «Гарри Поттера») комбинирует motion capture актеров с алгоритмами доработки: нейросеть «сглаживает» переходы между жестами, но ключевые кадры художник правит вручную. Так технологии не заменяют, а усиливают человеческий креатив, сокращая время работы.

Ключевые технологии липсинк

Распознавание речи и анализ фонем

Современные алгоритмы умеют разбивать речь на фонемы — звуковые «кирпичики» языка. Это позволяет нейросетям сопоставлять аудио не с целыми словами, а с микродвижениями губ. Например, платформа Descript использует эту технологию для автоматического редактирования видео: если вы исправляете текст в транскрипте, сервис меняет и артикуляцию говорящего в кадре.

Motion Capture (MoCap)

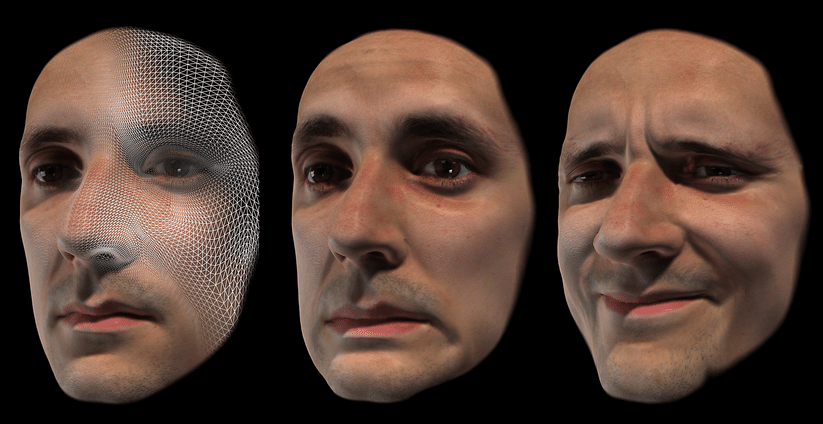

Motion Capture (MoCap) — это технология захвата движений реального человека или объекта для переноса их на цифрового персонажа. В контексте липсинк-видео MoCap фиксирует артикуляцию губ, мимику и движения лица с помощью специальных датчиков, камер или алгоритмов компьютерного зрения.

Как это работает?

- Сенсоры или маркеры размещаются на лице актера (например, вокруг губ, бровей, щек).

- Камеры или ИИ-алгоритмы записывают движения этих точек в пространстве.

- Данные преобразуются в цифровую анимацию, которая повторяет мимику актера с точностью до микродвижений.

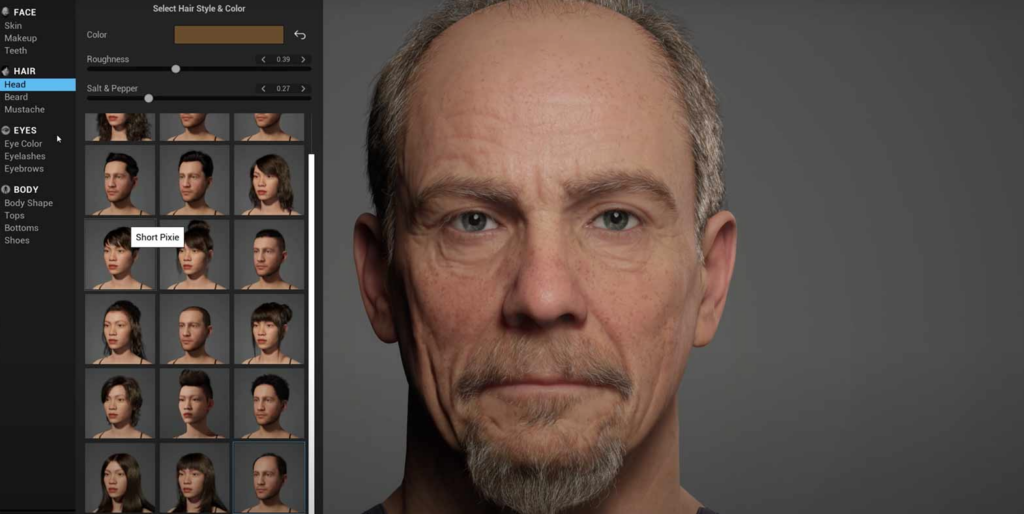

Технология MoCap, используемая в блокбастерах вроде «Аватара», доступна и для массового пользователя. Например, NVIDIA Audio2Face — облачный инструмент, который генерирует анимацию губ и мимики в реальном времени на основе аудио. Он интегрируется с Unreal Engine MetaHuman, позволяя создавать реалистичные диалоги для 3D-аватаров.

Reallusion iClone с плагином AccuLIPS автоматически анимирует губы персонажей, анализируя аудиодорожку. Это используют инди-разработчики игр для озвучки NPC без привлечения профессиональных аниматоров.

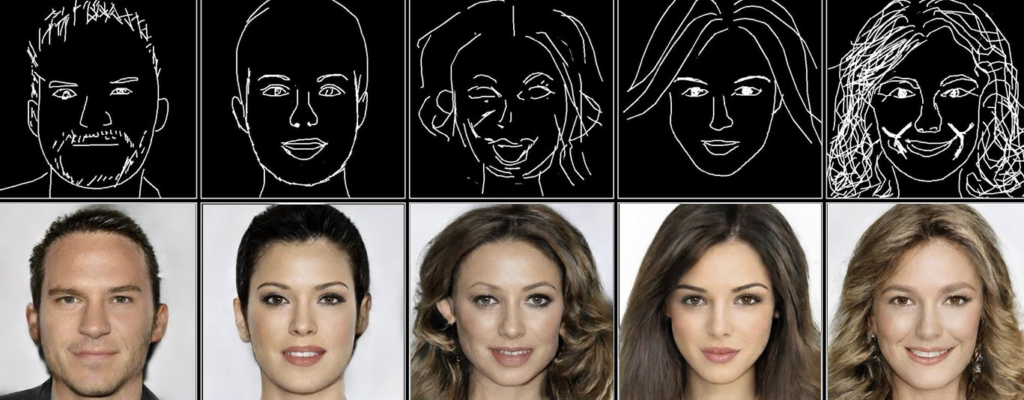

Генеративные нейросети

Генеративные нейросети — это алгоритмы ИИ, которые создают новый контент (анимацию, изображения, текст) на основе изученных данных. В липсинке они заменяют ручную анимацию и шаблоны: вместо того, чтобы копировать движения губ из базы, нейросеть генерирует их с нуля, анализируя аудиозапись.

GAN (Generative Adversarial Networks) и Diffusion-модели лежат в основе сервисов вроде Synthesia, где ИИ создает видео с цифровыми дикторами. Пользователь загружает текст, а нейросеть генерирует артикуляцию и мимику, совпадающую с речью.

Wav2Lip — открытый алгоритм, обученный на тысячах часов видео с TED-лекций. Он предсказывает движения губ даже для аудио, записанного в тишине, и используется в мемах и фанатских дубляжах.

Реалтайм-трекинг лица

Эту технологию популяризировали стримеры и виртуальные блогеры. Adobe Character Animator синхронизирует аватара с голосом пользователя через веб-камеру, отслеживая 52 точки на лице. А Vroid Studio (платформа для создания VTuber-аватаров) использует ИИ, чтобы «сглаживать» артефакты при быстрой речи.

Но самый впечатляющий пример — проект Unreal Engine MetaHuman. Его аватары в реальном времени повторяют мимику оператора, включая микродвижения губ при шепоте или смехе. Технологию уже тестируют в онлайн-образовании для персонализации лекций.

3D-морфинг и анимация

Это процесс моделирования мышц, кожи и костей лица в 3D-пространстве, чтобы движения губ выглядели анатомически точными. Например, в игре The Last of Us Part II инструмент FaceFX рассчитывает, как звук деформирует губы, щеки и даже язык персонажа. Такие алгоритмы учитывают физику тканей: например, при громком крике губы растягиваются сильнее, а кожа под глазами напрягается.

Для игр и 3D-анимации критична точная работа мышц лица. Например, при произношении «ф» верхние зубы касаются нижней губы — ИИ это учитывает.

Лучшие сервисы для генерации липсинк-видео

1. AI-платформы

App.vozo.ai

Vozo AI — это многофункциональная платформа для создания и редактирования видео с акцентом на синхронизацию губ, автоматические субтитры и мультиязычный дубляж. Сервис использует нейросети для анализа аудиодорожки и точного сопоставления движений губ с речью, даже при переводе контента на другие языки.

Ключевые функции:

- Автоматическая синхронизация губ: ИИ адаптирует мимику персонажей под аудио, включая эмоции и акценты.

- Клонирование голоса: Можно заменить голос в видео, сохраняя интонации и темп речи.

- Перевод и дубляж: Поддержка 127+ языков с синхронизацией артикуляции.

- Редактирование через текст: Изменяйте сценарий в транскрипте — нейросеть автоматически обновит видео и аудио.

Стоимость:

- Бесплатный. Для тестирования: 3 мин/месяц, 720p, 1 язык, 5 голосов, водяной знак.

- Стандартный ($7.99/месяц). Для блогеров: 60 мин/месяц, 1080p, 5 языков, 50+ голосов, удаление логотипа.

- Профессиональный ($18.99/месяц). Для команд: безлимит, 4K, 127 языков, клонирование голоса, интеграция с Adobe/Final Cut.

- Корпоративный (индивидуально). Для компаний: white-label, приватные серверы, кастомные голоса, NDA, обучение ИИ под бренд.

Runway (Gen-2)

Runway — одна из самых продвинутых AI-платформ для генерации видео, включая функцию Lip Sync. Она позволяет озвучивать фото и ролики, создавая реалистичную синхронизацию губ даже для статичных изображений 81013.

Ключевые функции:

- Озвучка фото и видео: Загрузите изображение и текст/аудио — нейросеть анимирует губы.

- Генерация видео из текста: Создает короткие ролики с нуля по описанию сцены.

- Глубокая стилизация: Например, превращение человека в мультяшного персонажа с сохранением мимики.

Стоимость:

- Бесплатный тариф: 125 кредитов (примерно 2.5 минуты видео).

- Платные подписки: от $12/месяц (12 минут видео) до $35/месяц (25+ минут).

Pika

Pika — нейросеть от разработчиков Стэнфорда, специализирующаяся на генерации коротких видео с опцией Lip Sync. Отличается простотой интерфейса и возможностью добавлять звуковые эффекты, синхронизированные с движением губ.

Ключевые функции:

- Синхронизация губ по аудио: Загрузите аудиофайл — ИИ анимирует губы на видео или фото.

- Стилизация под аниме/киберпанк: Генерация роликов в разных визуальных стилях.

- Расширение кадра: Добавление новых элементов в уже созданное видео (например, фоновые объекты).

Стоимость:

- Бесплатный тариф: 250 кредитов (25 роликов).

- Платные подписки: от $8/месяц (улучшенное качество и удаление водяного знака).

2. Мобильные приложения Lipsynk

TikTok

TikTok — самая популярная платформа для коротких видео, где липсинк стал ключевым элементом трендов. Приложение предлагает мощные инструменты для синхронизации движений губ с аудио, включая музыку, диалоги и мемы.

Особенности для липсинка:

- Библиотека звуков: Миллионы треков, диалогов из фильмов и мемов. Можно выбрать аудио и записать видео, синхронизируя губы в реальном времени.

- Точная настройка: Ручная регулировка скорости аудио и видео для идеального совпадения артикуляции.

- AR-эффекты: Маски с распознаванием лица, которые усиливают реалистичность синхронизации (например, анимированные губы поверх ваших).

- Дуэты и шаблоны: Повторяйте движения за другими пользователями или используйте готовые шаблоны для быстрого монтажа.

Triller

Triller сочетает автоматизацию монтажа с креативными инструментами, делая липсинк доступным даже новичкам. Алгоритмы приложения анализируют аудио и оптимизируют видео под ритм звука.

Особенности для липсинка:

- Автоматическая синхронизация: ИИ подстраивает движения губ под аудиодорожку, минимизируя ручную работу.

- Музыкальные миксы: 30-секундные отрывки из треков + возможность загружать свои записи.

- Стилизация под клипы: Готовые шаблоны с эффектами перехода, которые маскируют мелкие погрешности в артикуляции.

- Коллаборации: Совместные видео с другими пользователями, где синхронизация губ сохраняется даже при наложении дорожек.

Dubsmash

О сервисе:

Dubsmash — пионер среди липсинк-приложений, специализирующийся на озвучке цитат из фильмов, песен и мемов. Здесь легко воссоздать знаменитые диалоги с точной артикуляцией.

Особенности для липсинка:

- Коллекция шаблонов: Готовые аудиодорожки из поп-культуры с подсказками по движению губ.

- Редактор эмоций: Добавление улыбки, удивления или других выражений лица в процессе записи.

- Запись по частям: Можно снимать видео фрагментами, чтобы идеально подогнать артикуляцию к сложным аудио.

- Экспорт без логотипа: В платной версии (от $3.99/месяц) — сохранение роликов без водяного знака.

Заключение

Липсинк-видео из узкоспециализированной технологии превратился в инструмент массового творчества, охватывающий кино, соцсети, игры и образование.

Искусственный интеллект стал драйвером этой революции: нейросети вроде Wav2Lip и сервисы типа App.vozo.ai автоматизируют синхронизацию губ, делая ее доступной даже новичкам.

RU

RU EN

EN